在數字化轉型浪潮席卷全球的今天,數據已成為企業的核心資產與戰略資源。海量數據若缺乏有效的治理,不僅難以發揮價值,更可能成為負擔與風險源。作為數據治理體系的兩大核心支柱,數據標準管理與數據處理是確保數據質量、釋放數據潛能的關鍵。本文將深入剖析這兩大模塊的內涵、實踐方法與內在聯系,為企業構建堅實的數據基石提供系統性指引。

一、 數據標準管理:定義數據的“通用語言”

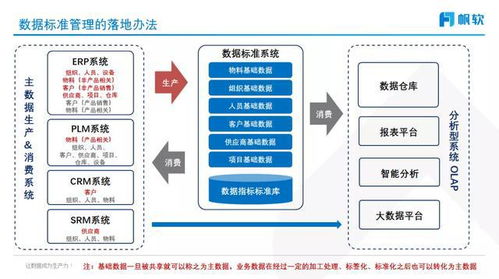

數據標準管理旨在為企業內部的數據定義、理解和使用建立統一的規范與規則,如同為數據制定一部“憲法”和“詞典”,確保數據在跨部門、跨系統流動時語義一致、格式統一。

1. 核心價值:

消除歧義,促進協同: 統一“客戶”、“產品”等關鍵業務實體的定義與屬性,打破部門墻導致的數據孤島。

提升質量,奠定基礎: 明確的數據格式、值域、約束規則,從源頭保障數據準確性與完整性。

支撐集成,加速分析: 標準化的數據是系統互聯互通和高效數據分析的前提。

滿足合規,控制風險: 滿足國內外日益嚴格的數據法規(如GDPR、個保法)對數據一致性與可解釋性的要求。

2. 關鍵實踐步驟:

現狀診斷與規劃: 識別關鍵業務領域和數據痛點,制定分階段、分主題的標準建設路線圖。

標準制定與設計: 組建跨職能團隊(業務+IT),共同制定基礎標準(如數據元、代碼值)、指標標準、模型標準等。遵循“業務驅動、技術落地”原則。

評審發布與宣貫: 建立正式的標準評審與發布流程,并通過培訓、文檔、工具等方式推動組織內部的理解與采納。

落地執行與監控: 將標準嵌入系統設計、開發流程與數據集成工具中。建立標準符合性檢查與度量機制。

* 持續維護與優化: 設立常設管理組織,建立標準變更流程,使之能隨業務發展而動態演進。

二、 數據處理:將原始數據轉化為可信資產

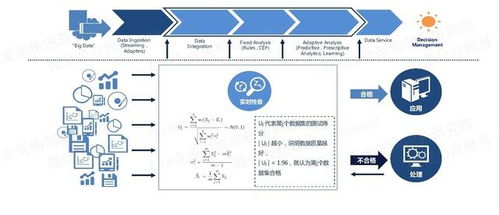

數據處理是指對數據進行采集、清洗、轉換、集成、加載等一系列操作的技術過程,是將原始、雜亂的數據加工成高質量、可用、可信數據資產的核心環節。

1. 核心環節與技術:

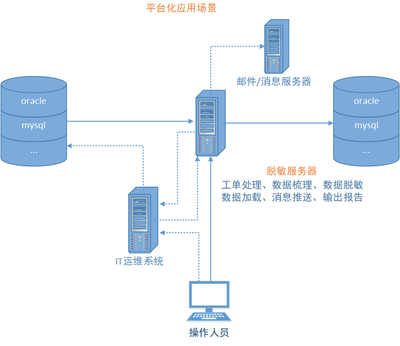

數據采集與接入: 從各類異構源系統(數據庫、API、日志、物聯網設備等)實時或批量獲取數據。

數據清洗與修正: 識別并處理缺失值、異常值、重復記錄、格式錯誤等,確保數據準確。

數據轉換與集成: 進行格式轉換、代碼轉換、業務規則計算、數據關聯/合并,形成統一視圖。

數據加載與存儲: 將處理后的數據加載到數據倉庫、數據湖或數據平臺等目標存儲中,供后續使用。

* 關鍵支撐技術: ETL/ELT工具、數據質量工具、實時流處理框架(如Flink)、數據集成平臺等。

2. 最佳實踐要點:

流程自動化與可編排: 構建可復用、可監控的自動化數據處理流水線,提升效率與可靠性。

質量嵌入與閉環管理: 在處理的每個關鍵節點設置質量檢查點,發現問題能追溯、能告警、能觸發修正流程。

元數據驅動: 基于數據標準(元數據)來驅動處理規則的配置與執行,確保處理過程有據可依。

性能與成本平衡: 根據業務時效性要求(實時/批處理)和成本考量,選擇合適的技術架構與資源調度策略。

三、 協同共進:數據標準與處理的閉環聯動

數據標準管理與數據處理并非孤立存在,而是構成了一個緊密咬合、持續優化的閉環:

- 標準指導處理: 數據標準為數據處理各環節提供了明確的規則依據。例如,清洗規則依據數據質量標準制定,轉換邏輯依據業務指標標準設計。

- 處理反饋標準: 數據處理過程中發現的數據質量問題、映射困難、性能瓶頸等,是檢驗標準合理性與完善度的重要輸入,能推動標準的迭代優化。

- 平臺化支撐: 現代數據治理平臺或數據中臺,正將標準管理能力(如標準庫、數據字典)與數據處理引擎深度集成,實現“定義即治理,處理即合規”的敏捷效果。

四、 與展望

有效的數據標準管理為企業數據建立了統一的“語言體系”和“法律框架”,而高效的數據處理則是將原始材料按照該體系加工成可用產品的“生產線”。二者相輔相成,共同構成了數據治理落地的“任督二脈”。

推進這項工作需要:高層賦予戰略重視,提供資源與授權;業務與IT深度融合,共同主導;采取循序漸進、價值驅動的實施路徑,從關鍵領域試點突破;并積極引入平臺化工具提升管理效率與自動化水平。

隨著人工智能技術的融合,數據標準的管理有望更加智能化(如自動發現與推薦),數據處理也將更加自動化與自適應。但核心邏輯不變:只有打好標準與處理這兩大基石,企業數據大廈才能穩固,數據驅動的智能決策與業務創新才能真正實現。